引言

图神经网络(Graph Neural Networks, GNN)是专门处理图结构数据的深度学习模型。与传统的神经网络不同,GNN能够有效处理非欧几里得空间的数据,如社交网络、分子结构和知识图谱等。

图神经网络的核心优势在于:

- 能够捕捉节点间的复杂关系

- 支持任意大小的图结构输入

- 保持图的拓扑结构不变性

近年来,GNN在多个领域取得了突破性进展,成为处理关系型数据的重要工具。

图论基础

图由节点(顶点)和边组成,可以形式化表示为 \( G = (V, E) \),其中 \( V \) 是节点集合,\( E \) 是边集合。每个节点可以包含特征向量,边可以有权重和方向。

图的表示

图通常用邻接矩阵 \( A \) 表示,其中 \( A_{ij} = 1 \) 表示节点 \( i \) 和 \( j \) 之间有边连接。节点特征矩阵 \( X \) 包含所有节点的特征向量。

其中 \( n \) 是节点数量,\( d \) 是特征维度。

图1: 图结构的基本组成,包括节点、边和特征

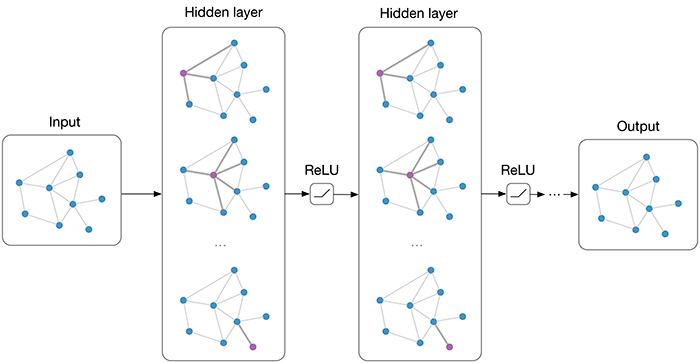

GNN架构

图神经网络通过消息传递机制更新节点表示。在每一层,节点聚合其邻居的信息,然后更新自身的表示。

消息传递框架

GNN的核心是消息传递,可以表示为:

其中 \( h_v^{(l)} \) 是节点 \( v \) 在第 \( l \) 层的表示,\( \mathcal{N}(v) \) 是节点 \( v \) 的邻居集合。

优缺点

- 优点:处理复杂关系数据,保持拓扑结构,可解释性强

- 缺点:计算复杂度高,对大规模图扩展性差,超参数敏感

图卷积网络

图卷积网络(Graph Convolutional Network, GCN)是最经典的GNN变体,通过图拉普拉斯矩阵的谱分解实现卷积操作。

GCN层公式

GCN的单层前向传播公式为:

其中 \( \tilde{A} = A + I \) 是带自连接的邻接矩阵,\( \tilde{D} \) 是度矩阵,\( W^{(l)} \) 是可学习权重矩阵。

图2: 图卷积网络的消息传递过程

图注意力机制

图注意力网络(Graph Attention Network, GAT)引入注意力机制,让节点能够为不同的邻居分配不同的重要性权重。

注意力系数计算

节点 \( i \) 对节点 \( j \) 的注意力系数为:

其中 \( \| \) 表示向量拼接,\( \mathbf{a} \) 是注意力向量,\( W \) 是共享的线性变换矩阵。

优缺点

- 优点:自适应邻居权重,处理异质图,性能优越

- 缺点:计算开销大,对噪声敏感,训练不稳定

应用场景

图神经网络在多个领域都有广泛应用:

社交网络分析

GNN可以用于社区检测、影响力分析和用户推荐。通过分析用户间的连接关系,GNN能够发现潜在的社交模式和用户兴趣。

推荐系统

在电商平台中,用户-商品交互可以构建为二分图。GNN通过消息传递学习用户和商品的嵌入表示,提高推荐准确性。

分子结构预测

在化学领域,分子可以表示为原子(节点)和化学键(边)构成的图。GNN能够预测分子的性质、反应活性等。

图3: 分子结构的图表示,原子为节点,化学键为边

代码实现

下面使用PyTorch Geometric库实现一个简单的图卷积网络:

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

class SimpleGCN(nn.Module):

def __init__(self, num_features, hidden_dim, num_classes):

super().__init__()

self.conv1 = GCNConv(num_features, hidden_dim)

self.conv2 = GCNConv(hidden_dim, num_classes)

def forward(self, data):

x, edge_index = data.x, data.edge_index

# 第一层GCN

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, training=self.training)

# 第二层GCN

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)图注意力网络实现

实现一个简单的图注意力网络:

import torch

import torch.nn as nn

from torch_geometric.nn import GATConv

class SimpleGAT(nn.Module):

def __init__(self, num_features, hidden_dim, num_classes, heads=8):

super().__init__()

self.conv1 = GATConv(num_features, hidden_dim, heads=heads, dropout=0.6)

self.conv2 = GATConv(hidden_dim * heads, num_classes, heads=1, concat=False, dropout=0.6)

def forward(self, data):

x, edge_index = data.x, data.edge_index

x = F.dropout(x, p=0.6, training=self.training)

x = F.elu(self.conv1(x, edge_index))

x = F.dropout(x, p=0.6, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)训练循环

基本的训练过程:

def train_model(model, data, optimizer, criterion):

model.train()

optimizer.zero_grad()

out = model(data)

loss = criterion(out[data.train_mask], data.y[data.train_mask])

loss.backward()

optimizer.step()

return loss.item()

# 使用示例

# model = SimpleGCN(num_features, 16, num_classes)

# optimizer = torch.optim.Adam(model.parameters(), lr=0.01, weight_decay=5e-4)

# criterion = nn.CrossEntropyLoss()结论

图神经网络为处理复杂的关系数据提供了强大的工具。从基础的图卷积网络到先进的图注意力机制,GNN在不断演进,解决着传统神经网络难以处理的问题。

关键要点总结:

- GNN通过消息传递机制有效捕捉图结构信息

- GCN和GAT是两种重要的GNN变体,各有优势

- GNN在社交网络、推荐系统、化学等领域有广泛应用

- 选择合适的GNN架构需要考虑具体任务和数据特性

随着研究的深入,图神经网络将继续在更多领域发挥重要作用,推动人工智能在处理复杂系统方面的发展。