引言

图神经网络(Graph Neural Networks, GNN)是专门用于处理图结构数据的深度学习模型。与传统的网格数据不同,图数据能够自然地表示实体之间的复杂关系,如社交网络、分子结构和知识图谱。

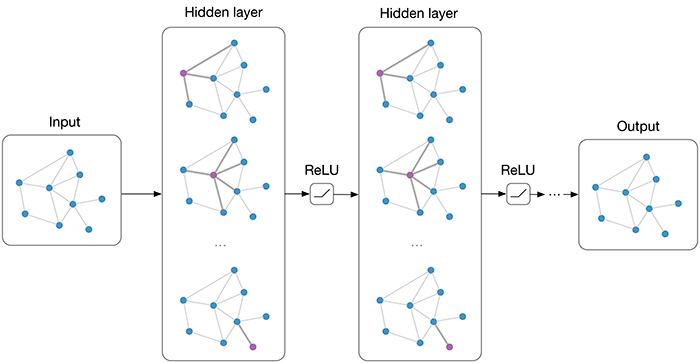

GNN的核心思想是通过消息传递机制,让节点从其邻居节点聚合信息,从而学习到包含图结构信息的节点表示。

图1: 图神经网络通过邻居节点聚合信息的基本原理

图数据基础

图由节点(vertices)和边(edges)组成,可以形式化表示为 \( G = (V, E) \),其中 \( V \) 是节点集合,\( E \) 是边集合。

图的表示

常用的图表示方法包括:

- 邻接矩阵:\( A \in \mathbb{R}^{n \times n} \),其中 \( A_{ij} = 1 \) 表示节点i和j相连

- 节点特征矩阵:\( X \in \mathbb{R}^{n \times d} \),每个节点有d维特征

- 度矩阵:对角矩阵,对角线元素为节点的度数

GNN架构原理

GNN通过多层消息传递来更新节点表示。在第k层,每个节点通过聚合其邻居节点的信息来更新自身表示:

其中 \( \mathcal{N}(v) \) 表示节点v的邻居集合,AGGREGATE是聚合函数,UPDATE是更新函数。

优缺点

- 优点:能处理任意图结构,捕捉复杂关系,对图变化鲁棒

- 缺点:计算复杂度高,过平滑问题,大规模图训练困难

图卷积网络

图卷积网络(Graph Convolutional Network, GCN)是最经典的GNN变体之一,通过谱图理论将卷积操作推广到图数据。

GCN层公式

GCN的单层传播规则为:

其中 \( \tilde{A} = A + I \) 是带自连接的邻接矩阵,\( \tilde{D} \) 是相应的度矩阵,\( W^{(l)} \) 是可学习参数。

图2: GCN的两层网络架构示意图

图注意力机制

图注意力网络(Graph Attention Network, GAT)引入了注意力机制,让节点能够为其不同的邻居分配不同的权重。

注意力系数计算

节点i对节点j的注意力系数计算:

其中 \( \| \) 表示拼接操作,\( \mathbf{a} \) 和 \( W \) 是可学习参数。

优缺点

- 优点:自适应邻居重要性,计算高效,inductive学习

- 缺点:注意力机制可能不稳定,超参数敏感

应用场景

GNN在多个领域都有广泛应用:

- 社交网络分析:用户推荐、社区发现、影响力分析

- 药物发现:分子性质预测、药物相互作用

- 推荐系统:基于用户-物品图的个性化推荐

- 知识图谱:关系推理、实体链接、问答系统

- 交通预测:基于路网的交通流预测

图3: GNN在不同领域的应用示意图

代码实现

下面使用PyTorch Geometric库实现基本的GCN和GAT模型:

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch_geometric.nn import GCNConv, GATConv

# 简单的GCN模型

class GCN(nn.Module):

def __init__(self, in_features, hidden_features, out_features):

super().__init__()

self.conv1 = GCNConv(in_features, hidden_features)

self.conv2 = GCNConv(hidden_features, out_features)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)

# GAT模型实现

class GAT(nn.Module):

def __init__(self, in_features, hidden_features, out_features, heads=8):

super().__init__()

self.conv1 = GATConv(in_features, hidden_features, heads=heads)

self.conv2 = GATConv(hidden_features * heads, out_features, heads=1)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.elu(x)

x = F.dropout(x, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)训练示例

模型训练的基本流程:

# 假设data包含x, edge_index, y等属性

model = GCN(in_features=1433, hidden_features=16, out_features=7)

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

def train():

model.train()

optimizer.zero_grad()

out = model(data.x, data.edge_index)

loss = F.nll_loss(out[data.train_mask], data.y[data.train_mask])

loss.backward()

optimizer.step()

return loss.item()

# 训练循环

for epoch in range(200):

loss = train()

if epoch % 20 == 0:

print(f'Epoch {epoch:03d}, Loss: {loss:.4f}')结论

图神经网络为处理关系数据提供了强大的工具,通过消息传递机制有效地捕捉图结构信息。从基础的GCN到更先进的GAT,GNN技术正在不断发展。

未来的发展方向包括:

- 处理动态图和时序图数据

- 提高大规模图的可扩展性

- 增强模型的可解释性

- 探索图神经网络与其他AI技术的融合

GNN在社交网络分析、药物发现、推荐系统等领域的成功应用,证明了其在处理复杂关系数据方面的巨大潜力。随着技术的成熟,GNN将在更多实际场景中发挥重要作用。